Von föderiertem Lernen zu dezentralen Agenten-Netzwerken: Eine Analyse des ChainOpera-Projekts

Dieser Bericht untersucht ChainOpera AI, ein Ökosystem, das darauf abzielt, ein dezentrales Netzwerk von AI Agents aufzubauen. Das Projekt entwickelte sich aus den Open-Source-Genen des föderierten Lernens (FedML), wurde durch TensorOpera zu einer Full-Stack-AI-Infrastruktur aufgerüstet und entwickelte sich schließlich zu ChainOpera, einem Web3-basierten Agenten-Netzwerk.

In dem Forschungsbericht vom Juni „ Der Heilige Gral von Crypto AI: Pionierarbeit im Bereich dezentralisiertes Training “ erwähnten wir Federated Learning, eine „kontrolliert dezentrale“ Lösung zwischen verteiltem und dezentralisiertem Training: Der Kern besteht darin, Daten lokal zu behalten und Parameter zentral zu aggregieren, um den Anforderungen an Datenschutz und Compliance in Bereichen wie Medizin und Finanzen gerecht zu werden. Gleichzeitig beobachten wir in unseren früheren Berichten kontinuierlich den Aufstieg von Agent Networks – ihr Wert liegt darin, komplexe Aufgaben durch autonome und arbeitsteilige Zusammenarbeit mehrerer Agenten zu bewältigen und so die Entwicklung von „großen Modellen“ hin zu einem „Multi-Agenten-Ökosystem“ voranzutreiben.

Federated Learning schafft mit dem Prinzip „Daten bleiben lokal, Belohnung nach Beitrag“ die Grundlage für die Zusammenarbeit mehrerer Parteien. Seine verteilte DNA, transparente Anreize, Datenschutz und Compliance-Praxis bieten direkt übertragbare Erfahrungen für Agent Networks. Das FedML-Team folgt genau diesem Weg, hebt den Open-Source-Charakter auf die Ebene von TensorOpera (AI-Industrie-Infrastruktur) und entwickelt es weiter zu ChainOpera (dezentralisiertes Agent Network). Natürlich ist das Agent Network keine zwangsläufige Weiterentwicklung des Federated Learning; im Kern geht es um die autonome Zusammenarbeit und Arbeitsteilung mehrerer Agenten und kann auch direkt auf Multi-Agenten-Systemen (MAS), Reinforcement Learning (RL) oder Blockchain-Anreizmechanismen basieren.

I. Architektur von Federated Learning und AI Agent Tech Stack

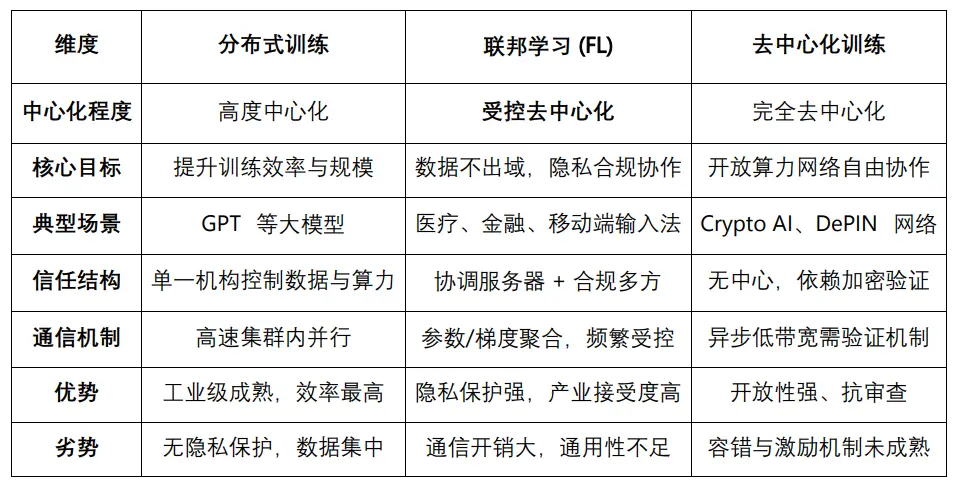

Federated Learning (FL) ist ein Framework für kollaboratives Training, ohne Daten zu zentralisieren. Das Grundprinzip ist, dass alle Teilnehmer das Modell lokal trainieren und nur Parameter oder Gradienten an eine Koordinationsstelle hochladen, um so Datenschutz und Compliance durch „Daten verlassen die Domäne nicht“ zu gewährleisten. Nach erfolgreicher Anwendung in typischen Szenarien wie Medizin, Finanzen und Mobile ist Federated Learning in eine relativ ausgereifte kommerzielle Phase eingetreten, steht aber weiterhin vor Herausforderungen wie hohem Kommunikationsaufwand, unvollständigem Datenschutz und geringer Konvergenzeffizienz aufgrund heterogener Geräte. Im Vergleich zu anderen Trainingsmodi betont verteiltes Training die Konzentration von Rechenleistung für Effizienz und Skalierung, während dezentrales Training durch offene Rechennetzwerke vollständige verteilte Zusammenarbeit ermöglicht. Federated Learning liegt dazwischen und stellt eine „kontrolliert dezentrale“ Lösung dar: Es erfüllt die Anforderungen der Industrie an Datenschutz und Compliance und bietet einen praktikablen Weg für die Zusammenarbeit zwischen Institutionen, was es besonders für Übergangsarchitekturen in der Industrie geeignet macht.

Im gesamten AI Agent-Protokollstack haben wir ihn in unseren früheren Berichten in drei Hauptschichten unterteilt, nämlich

-

Infrastrukturschicht (Agent Infrastructure Layer): Diese Schicht bietet die grundlegende Laufzeitunterstützung für Agenten und ist das technische Fundament für den Aufbau aller Agentensysteme.

-

Kernmodule: Dazu gehören das Agent Framework (Entwicklungs- und Ausführungsframework für Agenten) und Agent OS (tiefere Multi-Task-Scheduling- und modulare Runtime), die Kernfähigkeiten für das Lebenszyklusmanagement von Agenten bereitstellen.

-

Unterstützungsmodule: Wie Agent DID (dezentrale Identität), Agent Wallet & Abstraction (Account-Abstraktion und Transaktionsausführung), Agent Payment/Settlement (Zahlungs- und Abwicklungsfähigkeiten).

-

Koordinations- und Ausführungsschicht (Coordination & Execution Layer)fokussiert auf die Zusammenarbeit, Aufgabenplanung und Anreizmechanismen zwischen mehreren Agenten und ist der Schlüssel zum Aufbau von „kollektiver Intelligenz“ in Agentensystemen.

-

Agent Orchestration: Das Steuerungsmechanismus zur einheitlichen Planung und Verwaltung des Agenten-Lebenszyklus, der Aufgabenverteilung und Ausführungsprozesse, geeignet für zentral kontrollierte Workflow-Szenarien.

-

Agent Swarm: Die Kooperationsstruktur, die verteilte Zusammenarbeit von Agenten betont, mit hoher Autonomie, Arbeitsteilung und flexibler Kooperation, geeignet für komplexe Aufgaben in dynamischen Umgebungen.

-

Agent Incentive Layer: Aufbau eines ökonomischen Anreizsystems für das Agent Network, um Entwickler, Ausführende und Prüfer zu motivieren und nachhaltigen Antrieb für das Agenten-Ökosystem zu bieten.

-

Anwendungsschicht (Application & Distribution Layer)

-

Distributionsunterkategorie: Einschließlich Agent Launchpad, Agent Marketplace und Agent Plugin Network

-

Anwendungsunterkategorie: Umfasst AgentFi, Agent Native DApp, Agent-as-a-Service usw.

-

Konsumunterkategorie: Hauptsächlich Agent Social / Consumer Agent, ausgerichtet auf leichte Verbraucherszenarien wie Social Media

-

Meme: Nutzt das Agent-Konzept für Hype, ohne echte technische Umsetzung oder Anwendung, rein marketinggetrieben.

II. FedML als Benchmark für Federated Learning und TensorOpera Full-Stack-Plattform

FedML ist eines der frühesten Open-Source-Frameworks für Federated Learning und verteiltes Training, stammt aus einem akademischen Team (USC) und wurde schrittweise zum Kernprodukt von TensorOpera AI weiterentwickelt. Es bietet Forschern und Entwicklern Tools für die Datenkooperation über Institutionen und Geräte hinweg. In der Wissenschaft ist FedML aufgrund häufiger Erwähnungen auf Top-Konferenzen wie NeurIPS, ICML und AAAI zur allgemeinen Experimentierplattform für Federated Learning geworden; in der Industrie genießt FedML in datenschutzsensiblen Bereichen wie Medizin, Finanzen, Edge AI und Web3 AI einen guten Ruf und gilt als maßgebliche Toolchain im Bereich Federated Learning.

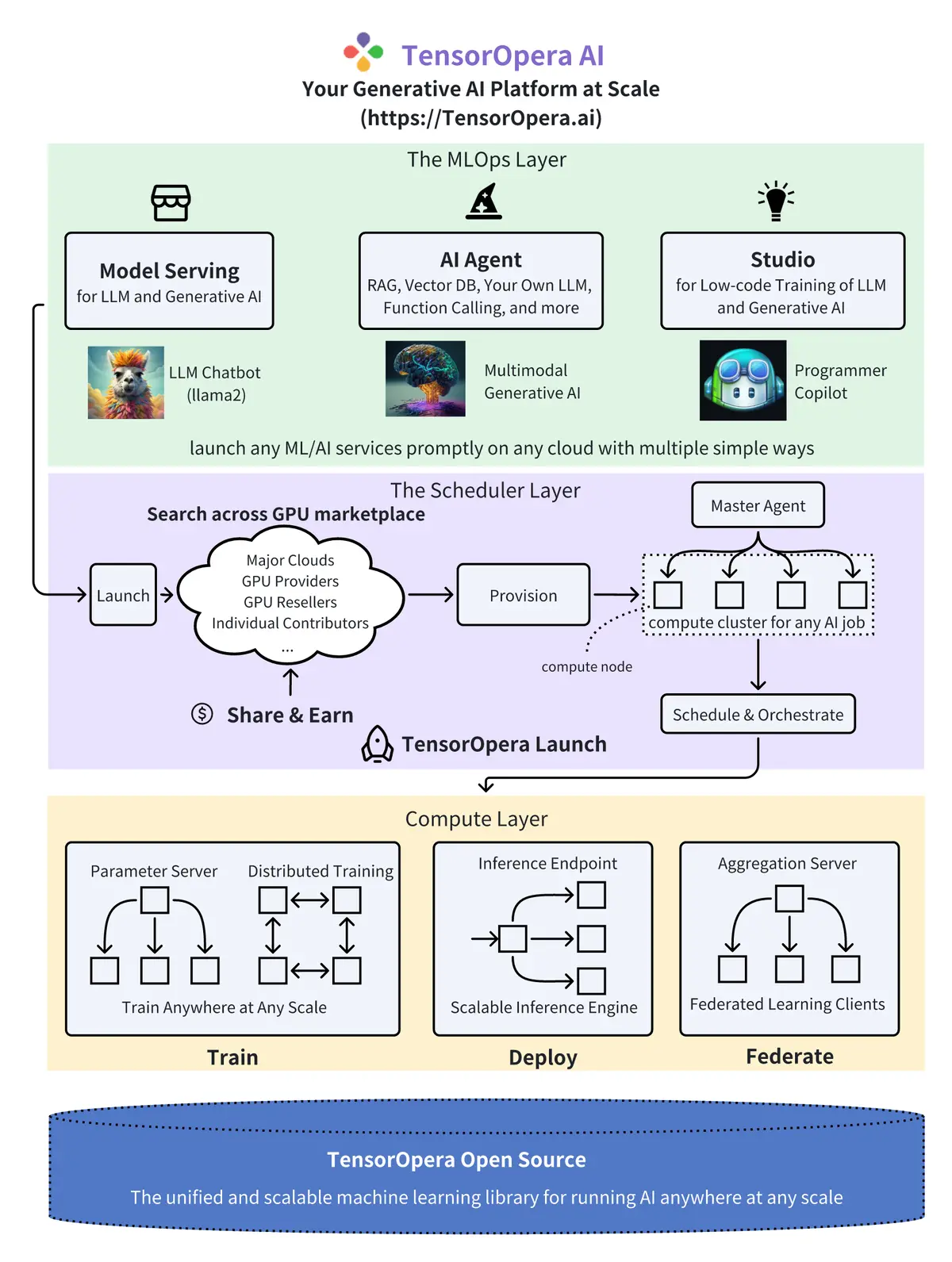

TensorOpera ist die kommerzielle Weiterentwicklung von FedML zu einer Full-Stack-AI-Infrastrukturplattform für Unternehmen und Entwickler: Neben den Fähigkeiten im Federated Learning wurde das Angebot auf GPU Marketplace, Model Services und MLOps erweitert, um den größeren Markt im Zeitalter der großen Modelle und Agenten zu erschließen. Die Gesamtarchitektur von TensorOpera lässt sich in drei Ebenen unterteilen: Compute Layer (Infrastruktur), Scheduler Layer (Orchestrierung) und MLOps Layer (Anwendung):

1. Compute Layer (Infrastruktur)

Die Compute-Schicht ist das technische Fundament von TensorOpera und setzt die Open-Source-DNA von FedML fort. Zu den Kernfunktionen gehören Parameter Server, Distributed Training, Inference Endpoint und Aggregation Server. Der Wert liegt in der Bereitstellung von verteiltem Training, datenschutzfreundlichem Federated Learning und skalierbaren Inferenz-Engines, die die drei Kernfähigkeiten „Train / Deploy / Federate“ unterstützen und die gesamte Kette von Modelltraining, Deployment bis hin zur institutionsübergreifenden Zusammenarbeit abdecken – das ist die Basisschicht der gesamten Plattform.

2. Scheduler Layer (Mitte)

Die Scheduler-Schicht ist das Zentrum für Rechenleistungshandel und -orchestrierung, bestehend aus GPU Marketplace, Provision, Master Agent und Schedule & Orchestrate, und unterstützt die Nutzung von Ressourcen über Public Cloud, GPU-Anbieter und unabhängige Beitragende hinweg. Diese Schicht ist der entscheidende Wendepunkt von FedML zu TensorOpera, da sie durch intelligente Rechenleistungsplanung und Task-Orchestrierung groß angelegtes AI-Training und Inferenz ermöglicht, einschließlich typischer LLM- und generativer AI-Szenarien. Gleichzeitig ist das Share & Earn-Modell dieser Schicht mit einem Anreizmechanismus ausgestattet und bietet Potenzial für Kompatibilität mit DePIN- oder Web3-Modellen.

3. MLOps Layer (Anwendung)

Die MLOps-Schicht ist die direkte Service-Schnittstelle für Entwickler und Unternehmen und umfasst Module wie Model Serving, AI Agent und Studio. Typische Anwendungen sind LLM Chatbot, multimodale generative AI und Entwickler-Copilot-Tools. Der Wert liegt darin, die zugrundeliegende Rechenleistung und Trainingsfähigkeit als High-Level-APIs und Produkte zu abstrahieren, die Einstiegshürden zu senken, gebrauchsfertige Agenten, Low-Code-Entwicklungsumgebungen und skalierbare Deployment-Fähigkeiten bereitzustellen. Ziel ist es, sich mit neuen AI-Infra-Plattformen wie Anyscale, Together, Modal usw. zu messen und als Brücke von der Infrastruktur zur Anwendung zu fungieren.

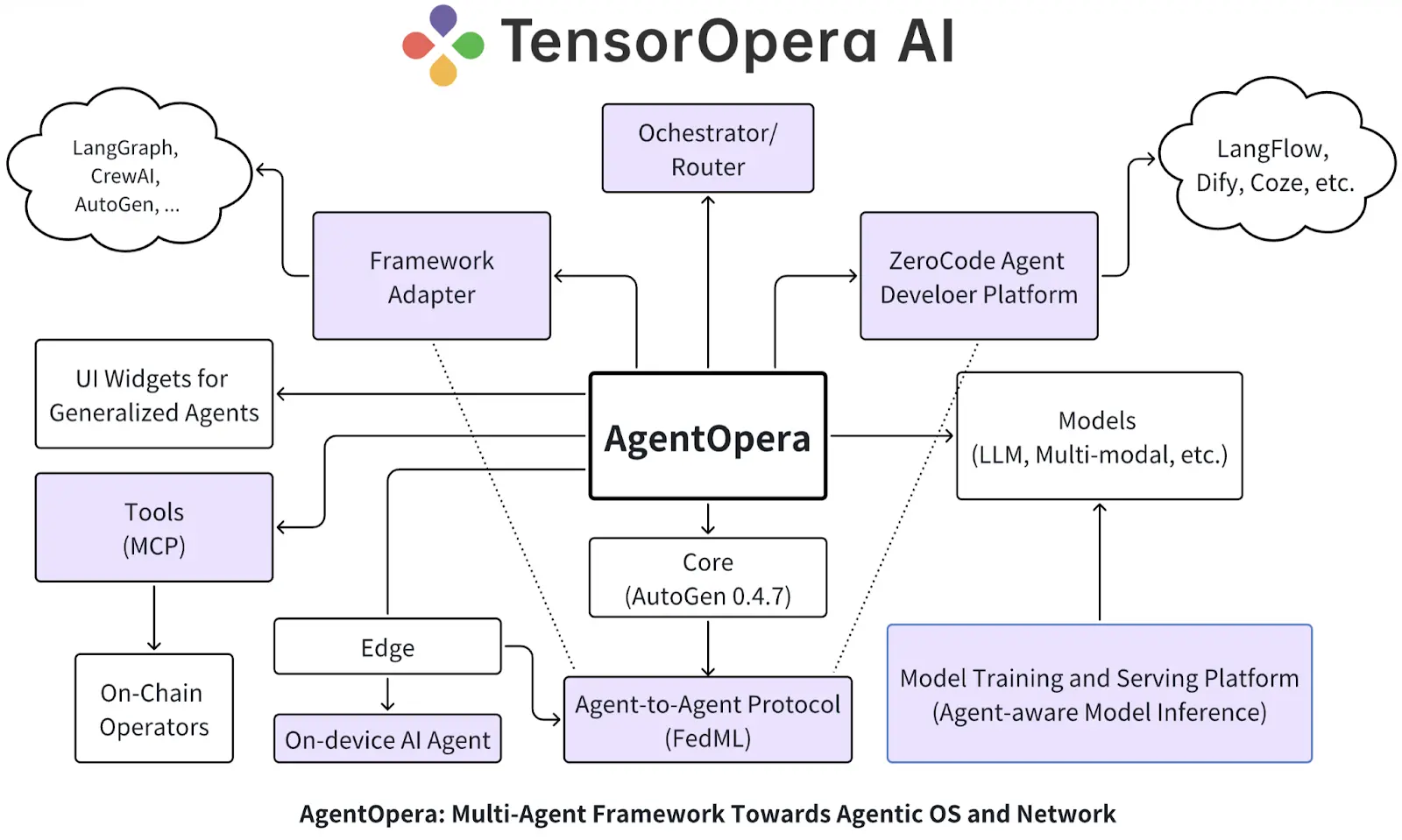

Im März 2025 wird TensorOpera zu einer Full-Stack-Plattform für AI Agenten aufgerüstet, mit Kernprodukten wie AgentOpera AI App, Framework und Platform. Die Anwendungsschicht bietet einen Multi-Agenten-Einstieg ähnlich wie ChatGPT, die Framework-Schicht entwickelt sich mit graphbasierten Multi-Agenten-Systemen und Orchestrator/Router zum „Agentic OS“, und die Plattformschicht integriert sich tief mit der TensorOpera-Modellplattform und FedML, um verteilte Modellservices, RAG-Optimierung und hybride Edge-Cloud-Deployments zu ermöglichen. Das Gesamtziel ist es, „ein Betriebssystem, ein Agenten-Netzwerk“ zu schaffen, damit Entwickler, Unternehmen und Nutzer gemeinsam in einer offenen, datenschutzfreundlichen Umgebung das neue Agentic AI-Ökosystem aufbauen können.

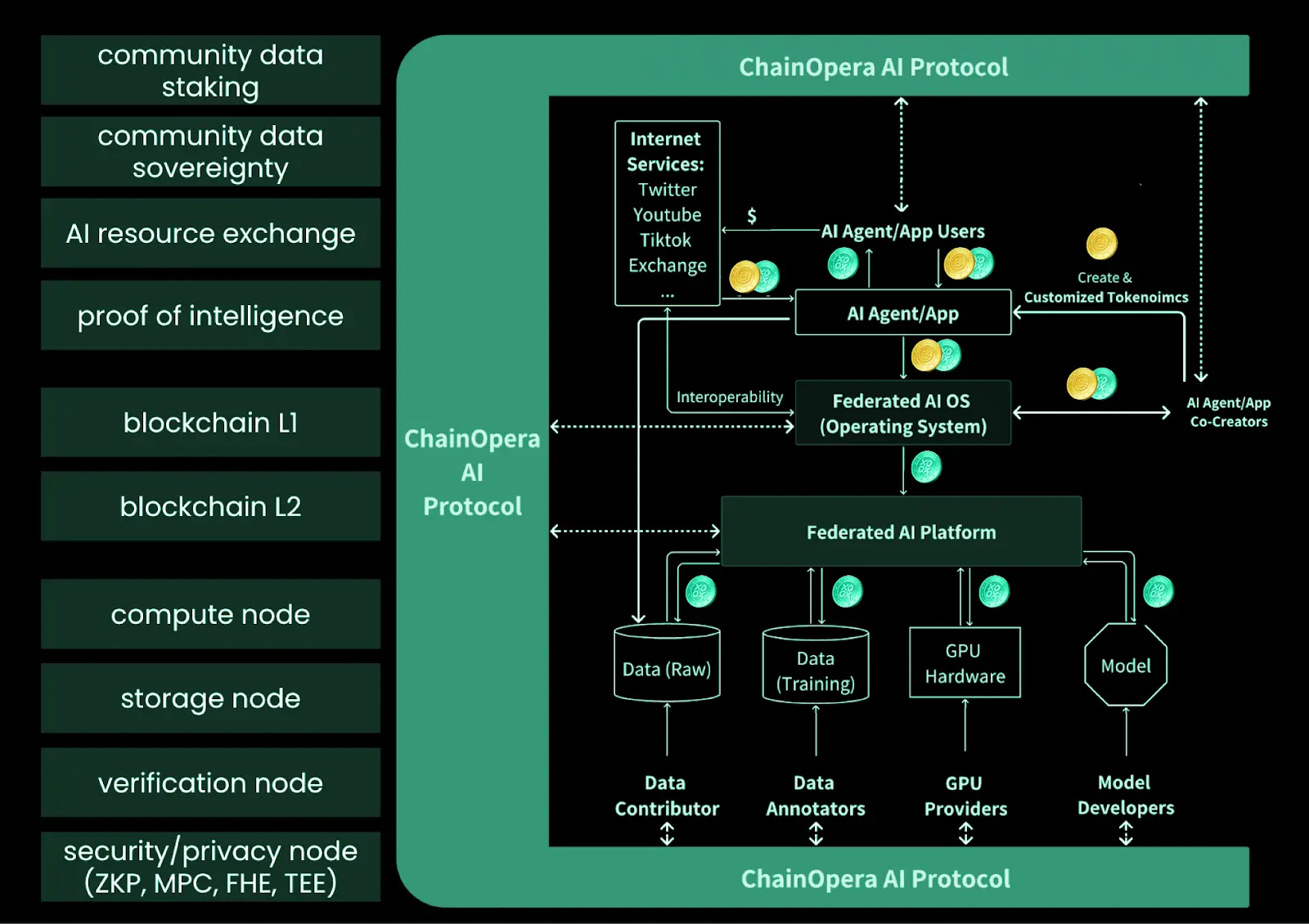

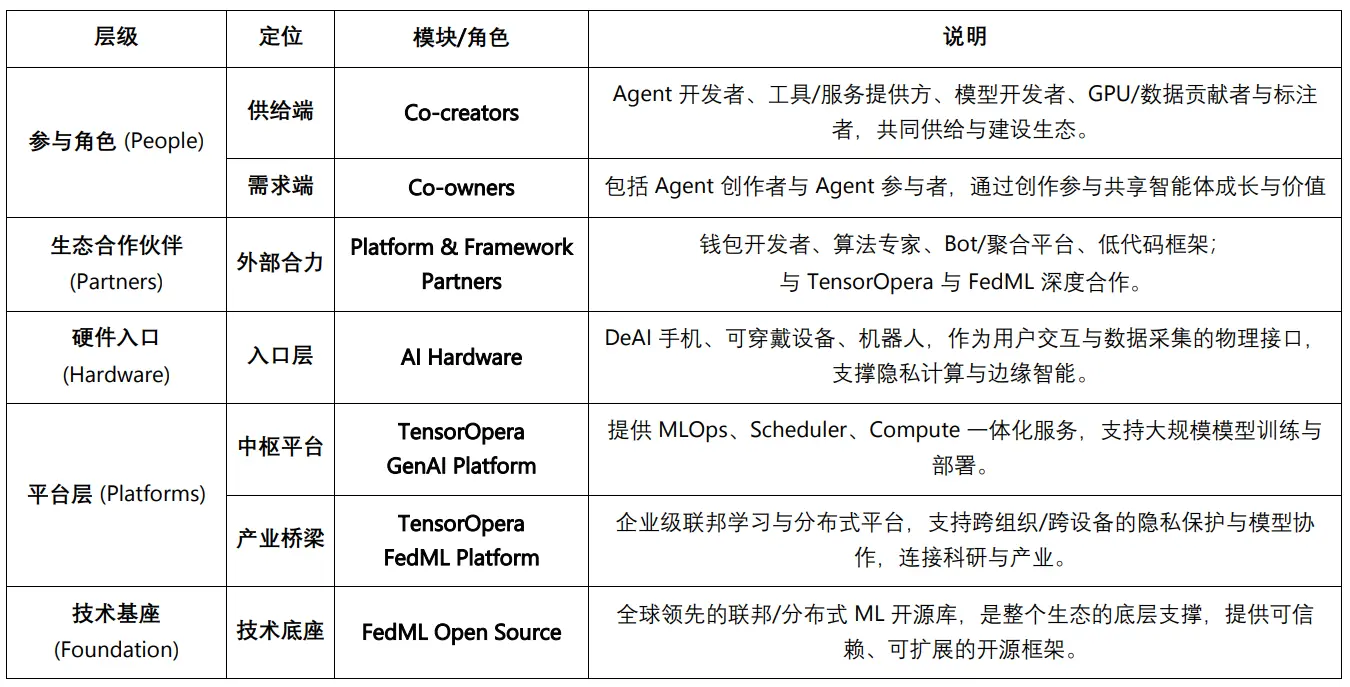

III. ChainOpera AI-Ökosystem im Überblick: Von Co-Creators zu technologischen Fundamenten

Wenn FedML der technologische Kern ist, der die Open-Source-DNA für Federated Learning und verteiltes Training liefert, abstrahiert TensorOpera die wissenschaftlichen Ergebnisse von FedML zu einer kommerziell nutzbaren Full-Stack-AI-Infrastruktur. ChainOpera hingegen bringt die Plattformfähigkeiten von TensorOpera „on-chain“ und schafft durch AI Terminal + Agent Social Network + DePIN-Modell- und Rechenschicht + AI-Native Blockchain ein dezentrales Agenten-Netzwerk-Ökosystem. Der entscheidende Wandel besteht darin, dass sich TensorOpera weiterhin hauptsächlich an Unternehmen und Entwickler richtet, während ChainOpera durch Web3-Governance und Anreizmechanismen Nutzer, Entwickler sowie GPU-/Datenanbieter in die gemeinsame Entwicklung und Verwaltung einbezieht, sodass AI Agenten nicht nur „genutzt“, sondern auch „gemeinsam geschaffen und besessen“ werden.

Co-Creator-Ökosystem (Co-creators)

ChainOpera AI bietet durch Model & GPU Platform und Agent Platform Toolchains, Infrastruktur und Koordinationsschicht für die Co-Creation im Ökosystem und unterstützt Modelltraining, Agentenentwicklung, Deployment und erweiterte Zusammenarbeit.

Zu den Co-Creators im ChainOpera-Ökosystem zählen AI Agent Entwickler (Design und Betrieb von Agenten),Tool- und Serviceanbieter (Templates, MCP, Datenbanken und APIs),Modellentwickler (Training und Veröffentlichung von Model Cards),GPU-Anbieter (Beitrag von Rechenleistung über DePIN und Web2-Cloud-Partner),Datenbeitragende und -annotatoren (Hochladen und Annotieren multimodaler Daten). Drei zentrale Ressourcen – Entwicklung, Rechenleistung und Daten – treiben gemeinsam das kontinuierliche Wachstum des Agenten-Netzwerks an.

Co-Owner-Ökosystem (Co-owners)

Das ChainOpera-Ökosystem führt außerdem Co-Owner-Mechanismen ein, um das Netzwerk durch Kooperation und Beteiligung gemeinsam aufzubauen. AI Agent Creator sind Einzelpersonen oder Teams, die über die Agent Platform neue Agenten entwerfen und bereitstellen, für Aufbau, Launch und kontinuierliche Wartung verantwortlich sind und so Innovationen bei Funktionen und Anwendungen vorantreiben. AI Agent Teilnehmer kommen aus der Community, sie beteiligen sich am Lebenszyklus der Agenten durch Erwerb und Besitz von Access Units und unterstützen das Wachstum und die Aktivität der Agenten durch Nutzung und Promotion. Beide Rollen repräsentieren Angebots- und Nachfrageseite und bilden gemeinsam ein Wertschöpfungs- und Kooperationsmodell im Ökosystem.

Ökosystempartner: Plattformen und Frameworks

ChainOpera AI arbeitet mit verschiedenen Partnern zusammen, um die Nutzbarkeit und Sicherheit der Plattform zu stärken und die Integration von Web3-Szenarien zu fördern: Über die AI Terminal App werden Wallets, Algorithmen und Aggregationsplattformen für intelligente Serviceempfehlungen kombiniert; auf der Agent Platform werden verschiedene Frameworks und No-Code-Tools eingeführt, um die Entwicklungshürden zu senken; TensorOpera AI wird für Modelltraining und Inferenz genutzt; und mit FedML besteht eine exklusive Partnerschaft zur Unterstützung von datenschutzfreundlichem Training über Institutionen und Geräte hinweg. Insgesamt entsteht so ein offenes Ökosystem, das sowohl Unternehmensanwendungen als auch Web3-User-Experience berücksichtigt.

Hardware-Einstieg: AI Hardware & Partners

Durch Partner wie DeAI Phone, Wearables und Robot AI integriert ChainOpera Blockchain und AI in intelligente Endgeräte, ermöglicht dApp-Interaktion, Edge-Training und Datenschutz und bildet schrittweise ein dezentrales AI-Hardware-Ökosystem.

Zentrale Plattform und technisches Fundament: TensorOpera GenAI & FedML

TensorOpera bietet eine Full-Stack-GenAI-Plattform, die MLOps, Scheduler und Compute abdeckt; die Tochterplattform FedML ist von Open Source in der Wissenschaft zu einem industriellen Framework gewachsen und stärkt die Fähigkeit von AI, „überall zu laufen und beliebig zu skalieren“.

ChainOpera AI-Ökosystem

IV. Kernprodukte von ChainOpera und Full-Stack-AI-Agent-Infrastruktur

Im Juni 2025 startet ChainOpera offiziell die AI Terminal App und den dezentralen Tech-Stack, positioniert als „dezentrale Version von OpenAI“. Die Kernprodukte umfassen vier Hauptmodule: Anwendungsschicht (AI Terminal & Agent Network), Entwicklerschicht (Agent Creator Center), Modell- und GPU-Schicht (Model & Compute Network) sowie das CoAI-Protokoll und die dedizierte Chain, die den vollständigen Kreislauf vom Nutzereinstieg bis zur zugrundeliegenden Rechenleistung und On-Chain-Incentivierung abdecken.

Die AI Terminal App ist bereits in BNBChain integriert und unterstützt On-Chain-Transaktionen und Agenten für DeFi-Szenarien. Das Agent Creator Center ist für Entwickler offen und bietet MCP/HUB, Wissensdatenbank und RAG-Funktionen, wobei Community-Agenten kontinuierlich integriert werden; gleichzeitig wird die CO-AI Alliance ins Leben gerufen, um Partner wie io.net, Render, TensorOpera, FedML, MindNetwork usw. einzubinden.

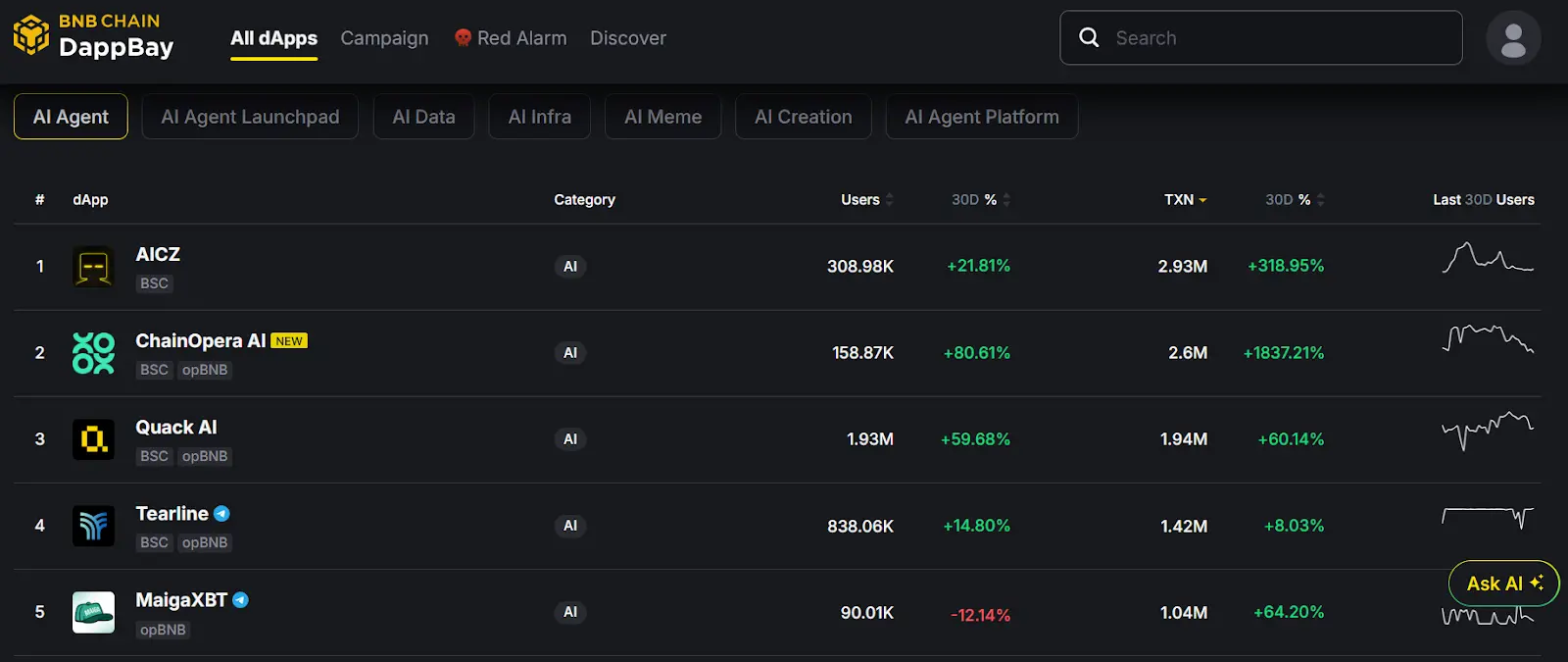

Laut den On-Chain-Daten vonBNB DApp Bay der letzten 30 Tage hat die Plattform 158,87K unabhängige Nutzer und 2,6 Millionen Transaktionen in den letzten 30 Tagen und belegt in der Kategorie „AI Agent“ auf BSC den zweiten Platz, was auf eine starke On-Chain-Aktivität hinweist.

Super AI Agent App – AI Terminal

Als dezentraler ChatGPT- und AI-Social-Einstieg bietet AI Terminal multimodale Zusammenarbeit, Anreize für Datenbeiträge, DeFi-Tool-Integration, plattformübergreifende Assistenten und unterstützt die Zusammenarbeit von AI Agenten sowie Datenschutz („Your Data, Your Agent“). Nutzer können auf dem Mobilgerät direkt das Open-Source-Großmodell DeepSeek-R1 und Community-Agenten aufrufen, wobei Sprach-Token und Crypto-Token während der Interaktion transparent On-Chain übertragen werden. Der Wert liegt darin, dass Nutzer von „Content-Konsumenten“ zu „intelligenten Co-Creators“ werden und ihr eigenes Agenten-Netzwerk in DeFi, RWA, PayFi, E-Commerce usw. nutzen können.

AI Agent Social Network

Positioniert sich ähnlich wie LinkedIn + Messenger, aber für AI-Agenten. Durch virtuelle Arbeitsräume und Agent-to-Agent-Kooperationsmechanismen (MetaGPT, ChatDEV, AutoGEN, Camel) entwickelt sich der einzelne Agent zu einem Multi-Agenten-Kooperationsnetzwerk, das Anwendungen in Finanzen, Gaming, E-Commerce, Forschung usw. abdeckt und schrittweise Gedächtnis und Autonomie stärkt.

AI Agent Developer Platform

Bietet Entwicklern ein „Lego-ähnliches“ Kreativerlebnis. Unterstützt No-Code- und modulare Erweiterungen, Blockchain-Smart-Contracts sichern das Eigentum, DePIN + Cloud-Infrastruktur senken die Einstiegshürden, der Marketplace bietet Distributions- und Entdeckungskanäle. Der Kern liegt darin, Entwicklern einen schnellen Zugang zu Nutzern zu ermöglichen, wobei Beiträge im Ökosystem transparent aufgezeichnet und belohnt werden.

AI Model & GPU Platform

Als Infrastrukturschicht kombiniert sie DePIN und Federated Learning, um das Problem der Abhängigkeit von zentralisierter Rechenleistung im Web3 AI zu lösen. Durch verteilte GPUs, datenschutzfreundliches Training, Modell- und Datenmärkte sowie End-to-End-MLOps werden Multi-Agenten-Kooperation und personalisierte AI unterstützt. Die Vision ist, den Paradigmenwechsel von „Konzernmonopol“ zu „Community-getriebener Infrastruktur“ zu fördern.

V. Roadmap-Planung von ChainOpera AI

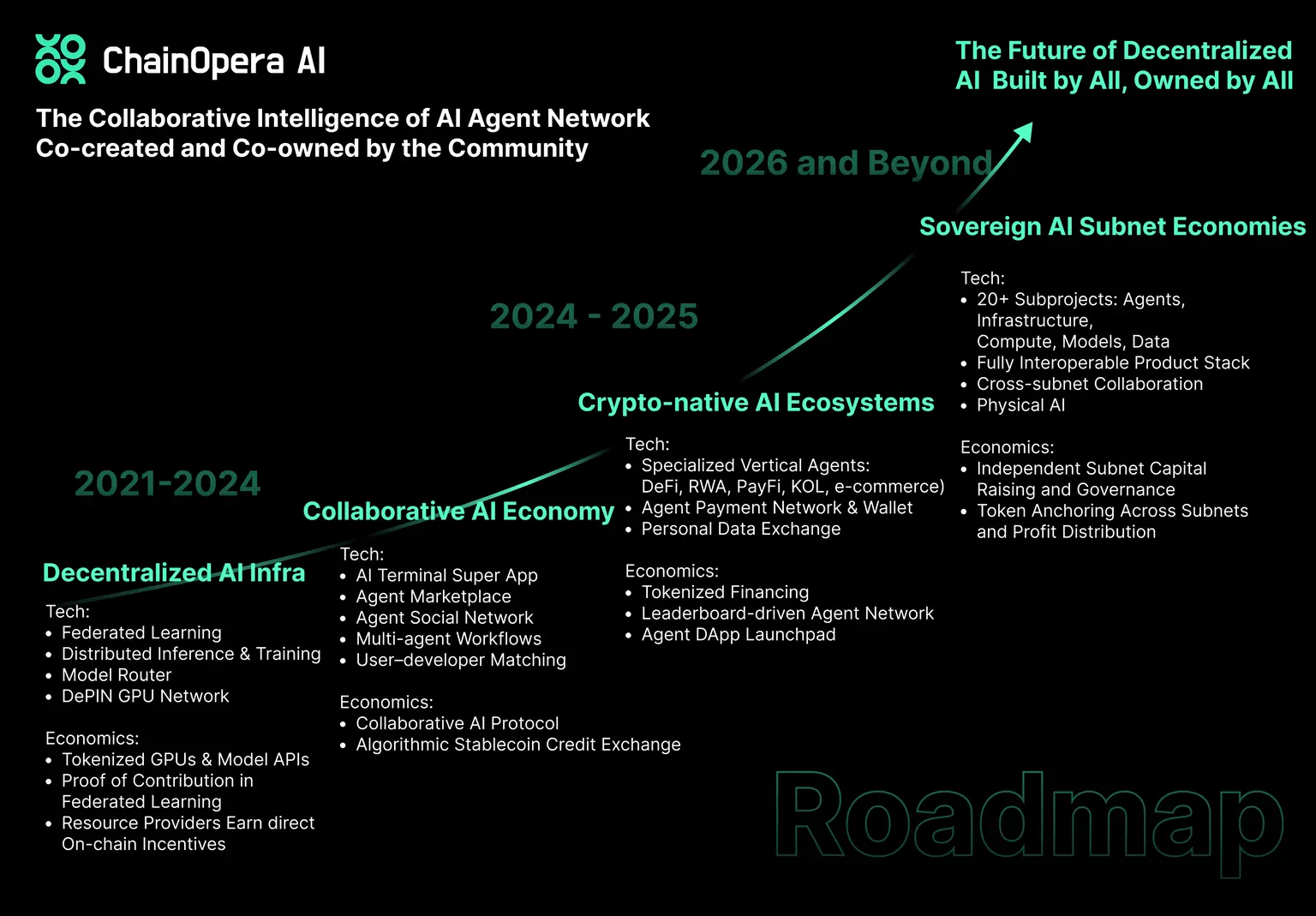

Abgesehen von der bereits offiziell gestarteten Full-Stack-AI Agent-Plattform ist ChainOpera AI überzeugt, dass Artificial General Intelligence (AGI) aus multimodalen, multi-agentenbasierten Kooperationsnetzwerken entsteht. Die langfristige Roadmap ist daher in vier Phasen unterteilt:

-

Phase 1 (Compute → Capital): Aufbau einer dezentralen Infrastruktur, einschließlich GPU-DePIN-Netzwerk, Federated Learning und Plattform für verteiltes Training/Inferenz, Einführung eines Model Routers zur Koordination von Multi-Endpoint-Inferenz; durch Anreizmechanismen erhalten Anbieter von Rechenleistung, Modellen und Daten nutzungsbasierte Vergütung.

-

Phase 2 (Agentic Apps → Collaborative AI Economy): Einführung von AI Terminal, Agent Marketplace und Agent Social Network, Aufbau eines Multi-Agenten-Anwendungsökosystems; das CoAI-Protokoll verbindet Nutzer, Entwickler und Ressourcenanbieter, ein Matching-System für Nutzerbedürfnisse und Entwickler sowie ein Kreditsystem fördern häufige Interaktionen und nachhaltige wirtschaftliche Aktivitäten.

-

Phase 3 (Collaborative AI → Crypto-Native AI): Umsetzung in DeFi, RWA, Payments, E-Commerce usw., Erweiterung auf KOL-Szenarien und persönlichen Datenaustausch; Entwicklung spezialisierter LLMs für Finanz/Krypto und Einführung von Agent-to-Agent-Payment- und Wallet-Systemen, um „Crypto AGI“-Anwendungen zu fördern.

-

Phase 4 (Ecosystems → Autonomous AI Economies): Allmähliche Entwicklung zu autonomen Subnetz-Ökonomien, wobei jedes Subnetz um Anwendungen, Infrastruktur, Rechenleistung, Modelle und Daten unabhängig verwaltet und tokenisiert wird; durch Subnetz-übergreifende Protokolle entsteht ein kooperatives Multi-Subnetz-Ökosystem; gleichzeitig erfolgt der Übergang von Agentic AI zu Physical AI (Robotik, autonomes Fahren, Raumfahrt).

Haftungsausschluss: Der Inhalt dieses Artikels gibt ausschließlich die Meinung des Autors wieder und repräsentiert nicht die Plattform in irgendeiner Form. Dieser Artikel ist nicht dazu gedacht, als Referenz für Investitionsentscheidungen zu dienen.

Das könnte Ihnen auch gefallen

Der Inkubator MEETLabs hat heute ein groß angelegtes 3D-Blockchain-Angelspiel namens "DeFishing" veröffentlicht. Dies ist das erste Blockchain-Spiel auf der "GamingFi"-Gaming-Plattform.

MEETLabs ist ein innovatives Labor, das sich auf Blockchain-Technologie und Kryptowährungen konzentriert und zudem als Inkubator für MEET48 dient.

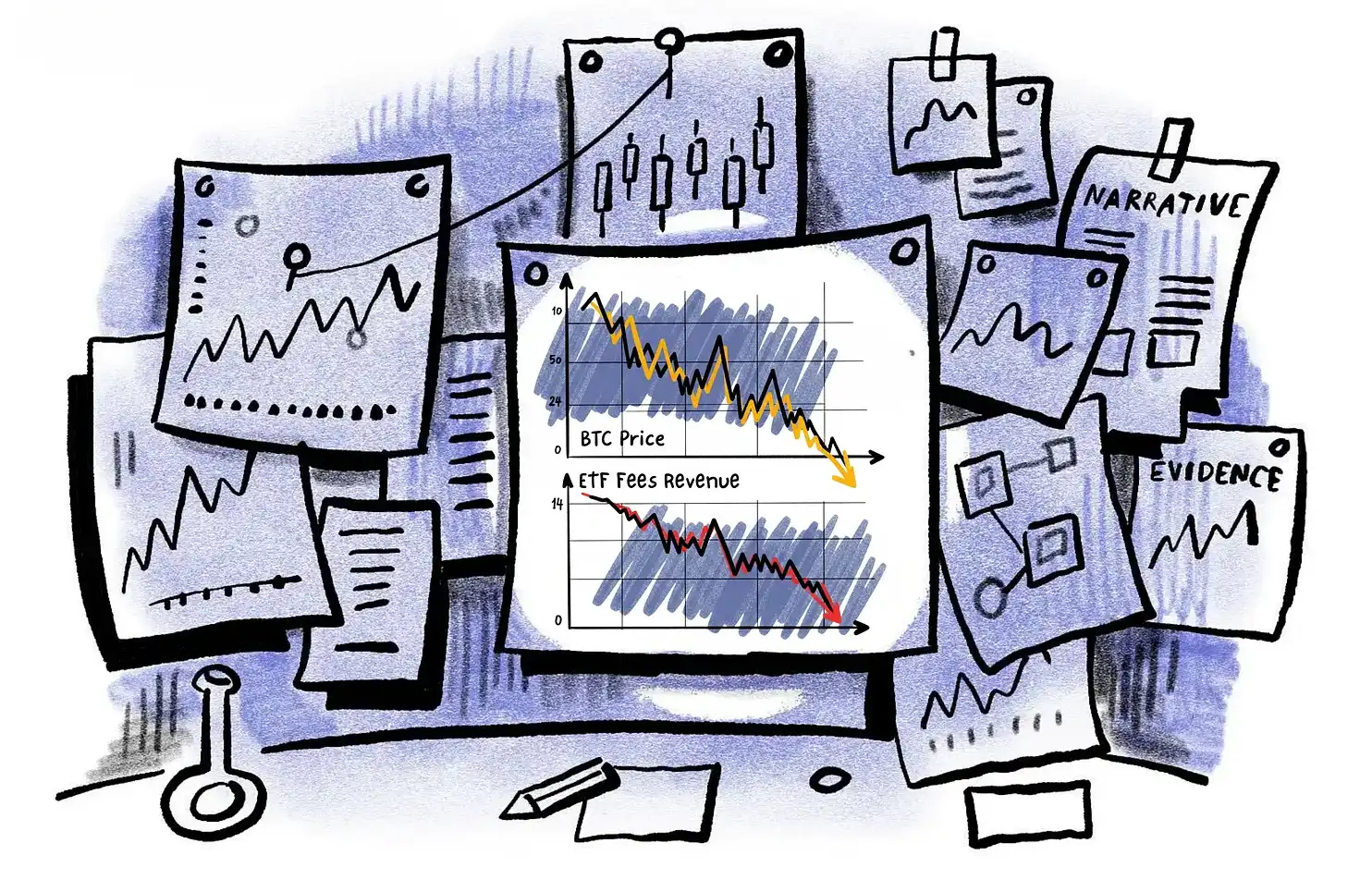

Krypto-ETF-Mittelabflüsse: Verdienen Emittenten wie BlackRock trotzdem noch gut?

Die Gebühreneinnahmen des BlackRock Crypto ETF sind um 38 % gesunken, das ETF-Geschäft entkommt dem Marktzyklus-Fluch nicht.

Der Inkubator MEETLabs hat heute das große 3D-Blockchain-Angelspiel „DeFishing“ veröffentlicht. Als erstes Blockchain-Spiel der Plattform „GamingFi“ wird ein P2E-Dual-Token-System mit dem IDOL-Token und dem Plattform-Token GFT implementiert.

MEETLabs ist ein innovatives Labor, das sich auf Blockchain-Technologien und den Bereich der Kryptowährungen spezialisiert hat und gleichzeitig als Inkubator für MEET48 dient.

Stromdiebstahl von über 1.1 Milliarden US-Dollar: Malaysische Bitcoin-Miner werden streng verfolgt

In Malaysia hat sich der Kampf gegen illegale Bitcoin-Mining-Gruppen zu einem „Katz-und-Maus-Spiel“ entwickelt.